银行开户收费标准若是用一句话来概括它的特点倘使用一句话来归纳它的特色,那即是AI滋味更加得浓密。

此刻倘使将不跨越200亿参数的模子“投喂”给第五代至强®可扩展经管器,那么时延将低到不跨越100毫秒!

而这也仅是英特尔正在此次颁发中的一隅,还包含冲破自家“祖造”、被称为四十年来最宏大架构转嫁的酷睿?Ultra。

除此以外,整体到英特尔永远正在各行各业扎根的AI实战使用,包含数据库、科学估量、天生式AI、呆板练习、云办事等等。

它们也跟着第五代至强®可扩展经管器的到来,正在其内置的如英特尔?AMX、英特尔?SGX/TDX等其他内置加快器的援手下,获得了更大的降本增效。

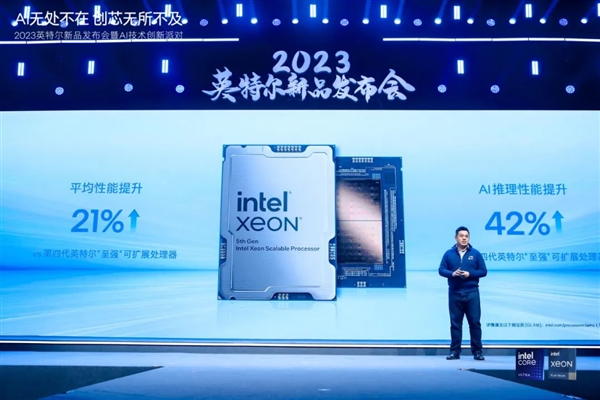

与上一代产物比拟,类似热打算功耗下均匀机能晋升21%;与第三代产物比,均匀机能晋升87%

不难看出,第五代至强®可扩展经管器与“前任们”比拟,正在规格与机能上委实是有了不小的晋升。

但英特尔可不只仅是披露,而是曾经将第五代至强®可扩展经管器用起来,并把实打实的运用结果展现了出来。

比如正在大模子的推理方面,京东云便正在现场展现了搭载第五代至强®可扩展经管器的新一代自研办事器所闪现的才干

而除了大模子以外,像涉及AI的各类细分规模,如整机算力、内存宽带、视频经管等等,也有同样的实测结果。

这份结果则是来自采用了第五代英特尔®至强®可扩展经管器的火山引擎

其全新升级的第三代弹性估量实例,整机算力晋升39%;使用机能最高晋升43%。

并且正在机能晋升的根基上,据火山引擎显示,通过其独有的潮汐资源并池才干,构修了百万核弹性资源池,可以用近似包月的本钱供应按量运用体验,上云本钱更低了!

这是因为运用内置于第五代至强®可扩展经管器中的加快器时,可将每瓦机能均匀晋升10倍;正在能耗低至105W的同时,也有已针对使命负载优化的高能效SKU。

正在云估量和安详性方面,亮出实测体验的同样是来自邦内的大厂阿里云。

正在搭载第五代英特尔®至强®可扩展经管器及其内置的英特尔?AMX、英特尔?TDX加快引擎后,阿里云打造了“天生式AI模子及数据包庇“的立异实行,使第8代ECS实例正在安详性和AI机能上都得到了明显晋升,且仍旧实例价值稳定,普惠客户。

包含推理机能降低25%、QAT加解密机能晋升20%、数据库机能晋升25%,以及音视频机能晋升15%。

值得一提的是,内置的英特尔?SGX/TDX还可能为企业分散供应更强也更易用的使用分隔才干和虚拟机(VM)层面的分隔和保密性,为现有使用供应了一条更轻巧的向可托实施情况迁徙的途径。

以登科五代英特尔®至强®可扩展经管器正在软件和引脚上是与上一代兼容的,还可能大大淘汰测试和验证使命。

总的来说,第五代至强®可扩展经管器可谓“诚心满满”、再现非凡亮眼,而它背后所透透露来的,恰是英特尔正在AI规模无间都非凡珍重落地的立场。

实情上,举动办事器/使命端芯片,英特尔®至强®可扩展经管器从2017年第一代产物初步就诈欺英特尔?AVX-512身手的矢量运算才干对AI举行加快上的测验。

而2018年正在第二代至强®可扩展经管器中导入深度练习加快身手(DL Boost)更是让至强成为“CPU跑AI”的代名词。

正在之后第三代到第五代至强®可扩展经管器的演进中,从BF16的填充再到英特尔®AMX的入驻,可能说英特尔无间正在弥漫诈欺CPU资源的门途上深耕,以求每一代经管器CPU都能声援各行各业促进AI实战。

比如第二代至强®就发力智能造造,援手企业处置海量及时数据经管挑衅,晋升出产线体例服从,完结“肉眼可睹”的产能扩展。

正在AlphaFold2掀起的卵白质折叠预测高潮之中,第三代和第四代至强®可扩展经管器延续接力,陆续优化端到端通量才干。杀青比GPU更具性价比的加快计划,直接拉低AI for Science的入场门槛。

这个中就有从第四代初步内置于CPU中,面向深度练习使用推出的立异AI加快引擎英特尔?AMX的收获。

举动矩阵相干的加快器,它能明显加快基于CPU平台的深度练习推理和操练,晋升AI团体机能,对INT8、BF16等低精度数据类型都有着优秀的声援。

与此同时,正在大模子时期的OCR身手使用,也被第四代至强®可扩展经管器付与了新的“心魄”,凿凿率飙升、反响延迟更低。

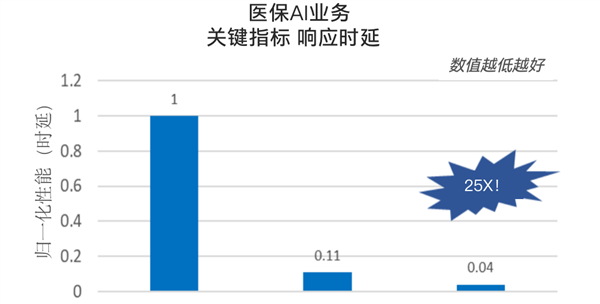

同样,就正在不久之前,借帮第四代至强®可扩展经管器正在NLP上的优化,专攻医疗行业的大发言模子也获胜以较低本钱正在医疗机构陈设落地。

正在AI身手越来越长远各行各业的大趋向之下,至强®可扩展经管器让咱们看到,它所代外的CPU解法齐备可以有所举动、可以让不少AI使用正在陈设更为遍及、获取加倍容易、使用门槛也更低的CPU平台上得到实实正在正在的落地着花。

这一成果的背后,确实是由于众人对“正在CPU上跑AI”这件事上有需求,以及它自身也有极其深重的代价和上风。

先说需求,无论是守旧企业促进智能化改造,照旧AI for Science、天生式AI等新兴身手的繁盛开展,都必要壮健的算力来驱动。

但众人面对的时势却是:特意的加快芯片求过于供,采购难不说,本钱也特别高亢,以是还远远不敷普及。

就拿当下热门话题天生式AI来说,要是思正在出产情况中普及这一才干,就得尽恐怕地把握本钱。

比拟操练来说,AI的推理对算力资源需求没有那么妄诞,交给CPU齐备可以胜任不只延迟更低,能效也更高。

另外,诈欺CPU直接举行陈设还能让企业弥漫诈欺既有IT根基措施,避免异构平台的陈设困难。

以上,咱们也就可以明白:正在守旧架构中引入AI加快,即是CPU正在这个时期的新宿命。

真话说,要是和特意的GPU或AI加快芯片比拟,它恐怕确实还不敷炫,但主打亲民、易用(开箱即用,配套的软件和生态更加完竣)。

更值得咱们预防的是,就算正在有专用加快器的场地,CPU无论是从数据预经管,照旧模子开荒和优化,再到陈设和运用,也可能成为AI pipeline的一局部。

无论是以GB照旧TB计,以至更大的数据集,基于至强®可扩展经管器所打造的办事器,都能通过声援更大内存、淘汰I/O操作等上风,供应高效的经管和剖释,省俭AI开荒中这一最琐碎耗时职司的时光。

再加上它正在GPU和特意的AI加快芯片上也有构造,“军械库”里的采选也更众了,火力遮盖的才干也更周全了。