外汇品种中英文对照美光:跳过第四代HBM3上一篇作品《AI内存瓶颈(上):3D NAND道途图》中咱们对数据存储举办了梳理,并重心先容了ROM中的3D NAND时间道理与市集景况。存储芯片市集中,基于闪存Flash时间的NAND是重要外部存储器,而DRAM是重要的内部存储器,二者协同盘踞全数半导体存储市集高出97%的份额,也正在各自的界限饰演着相当紧要的脚色。上一篇咱们梳理了NAND,本篇接着梳理内存芯片DRAM。

正在AI鞭策的算力需求发作中,GPU无疑是算力系统中最焦点、受到合怀最众、销量增加最速的细分赛道。可是思要使GPU能高效地做事,电脑/任职器举座的效用也要提上来,这此中最紧要的配套产物或者即是内存了,而HBM时间因为其高带宽、低功耗、大容量的特性便成为了GPU的好兄弟。本篇最初先容DRAM内存芯片的重要分类和道理,然后梳理DRAM产物更加是HBM的迭代进程和成长趋向,再先容家当链和市集景况,结果总结邦内相干企业。

RAM是半导体存储器中的易失性存储器,须要电源来保卫存储的新闻,因为它能够直接探访大肆存储单位而也被叫为随机探访(Random Access Memory)。RAM又分为SRAM和DRAM,前者用于CPU缓存,后者则用于内存,都属于策画机内部存储器(或是主存储器),与固态硬盘SSD、U盘等外部非易失性存储器相对。SRAM和DRAM容量远低于SSD,但探访速率极速。

SRAM(静态随机存取)运用双稳态的触发器来存储每个位,普通由6个晶体管构成,只须电源无间,数据就会仍旧稳固。SRAM因为它不须要改善的特点而供应极速的探访速率,因而被用作CPU缓存。可是,SRAM产物正在全数存储市集中的份额很少,因而咱们重心合怀份额高出50%的DRAM产物。

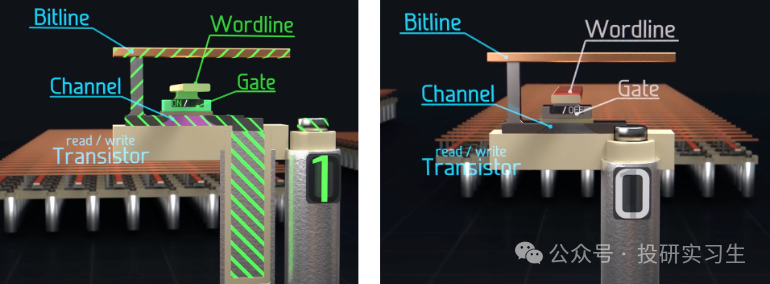

DRAM(动态随机存取)的道理和SRAM分别,它的基础存储单位由一个晶体管(Transistor)和一个电容器(Capacitor)组成,也被称为1T1C。晶体管动作开合节造是否允诺电荷的流入或流出,电容器则用来存储电荷。当电容器充满电后默示1,未充电时则存储0。

从机合上看,和2D NAND肖似,DRAM是一个二维阵列,一整行晶体管的节造栅由一条字线(Wordline)相连,一整列的晶体管由位线(Bitline)相连。晶体管通过地点线被激活,允诺对应的电容通过数据线读取或转化电荷形态。

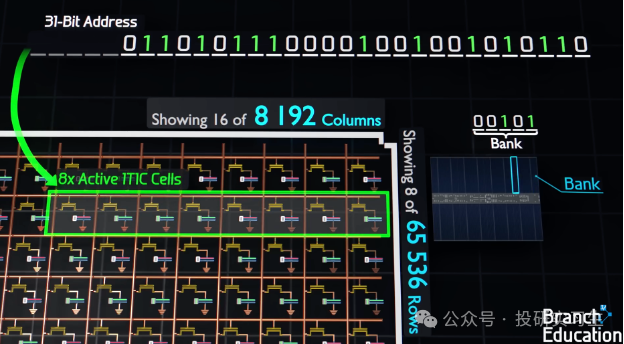

以下图为例,正在一个由众个1T1C单位(一个晶体管和一个电容)构成的DRAM阵列中,每个阵列被称为一个库(Bank),而一个芯片(Die)能够包蕴众个如许的Bank。为了定位存储单位,策画机运用一个31位的地点线位用于遴选全部的Bank,接下来的16位用于激活指定的行(Row),结果的10位则用于同时激活8个列(Column)。

如许的打算使得正在一次操作中能够选定一个特定行,并同时探访众个列。DRAM之以是称为“动态”随机存取存储器,是由于它存储的电荷会随时刻泄露,因而须要按期举办电荷的改善以保卫数据的完备性。

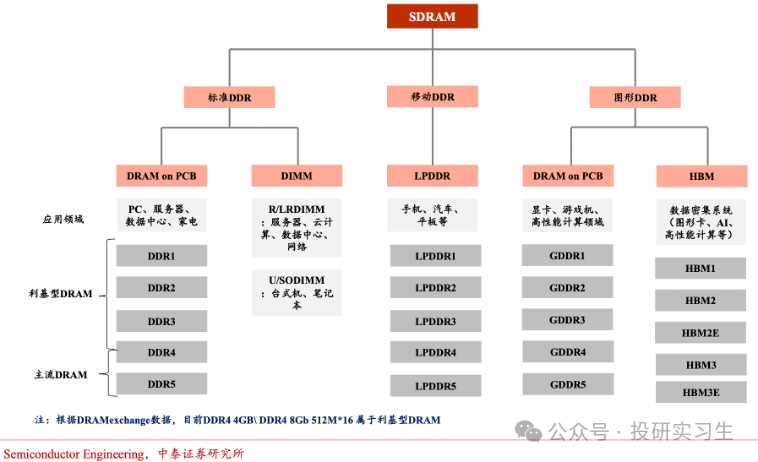

DRAM能够按用处分为尺度DDR、转移DDR和图形DDR三种,他们的底层DRAM单位相仿,但举座上有分别架构。DDR全名为双倍数据率同步动态随机存取存储器(Double Data Rate SDRAM),能够正在每个时钟周期的上升沿和降落沿都能传输数据,从而升高数据传输率,重要用于任职器和电脑。

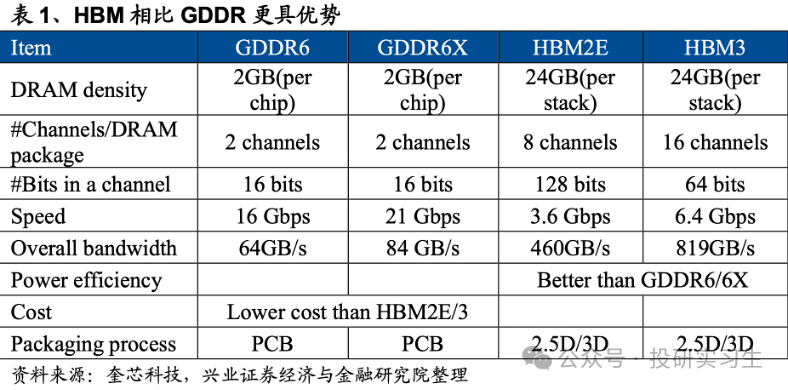

转移DDR运用LPDDR尺度(Low Power DDR),专为转移摆设如手机和汽车打算,具有较低功耗的特点。图形DDR全名为GDDR(Graphics DDR),专为图形和AI加快策画打算,声援高带宽、高速度的数据传输,实用于管造洪量图形。别的,HBM也属于图形DDR。

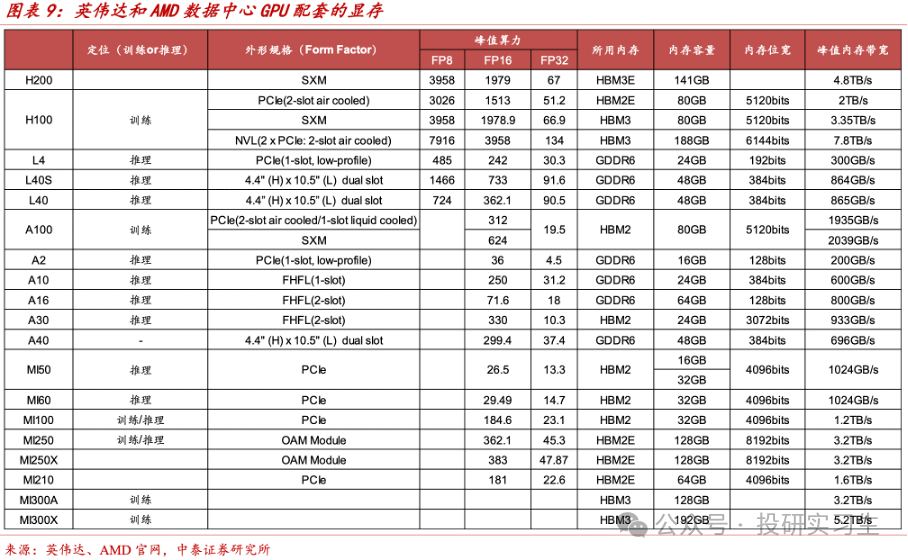

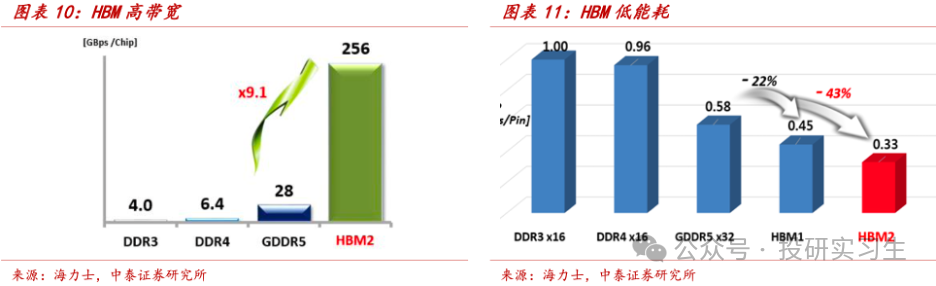

正在全部行使层面,DDR和LPDDR重要面向CPU,而GDDR和HBM则洪量行使于GPU显存。因为HBM精华的大容量、高带宽和低功耗等上风,现时主流AI熬炼卡都搭载采用HBM时间的显存,而GDDR则因其本钱上风更有性价比被更众用于AI推理卡。

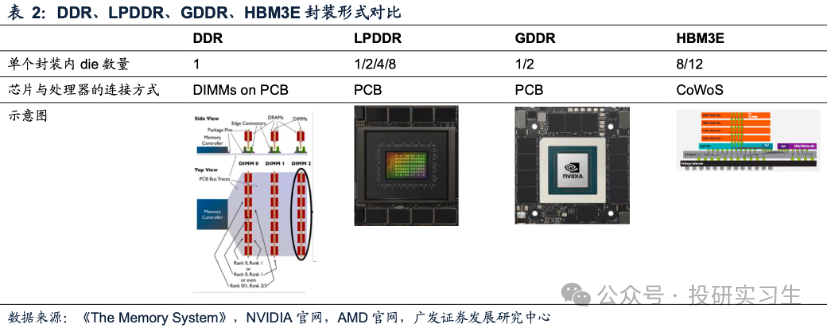

前面所描摹过的机合是一个DRAM芯片的内部,也即是一个Die,一个DDR模组上包蕴众个Die。DDR模组通过DIMM(双列直插式内存模块Dual line memory module)的大局结构,封装好的DRAM被安设正在小型PCB电途板上,能够直接插入主板上的DIMM插槽,再通过主板 PCB和管造器通讯。

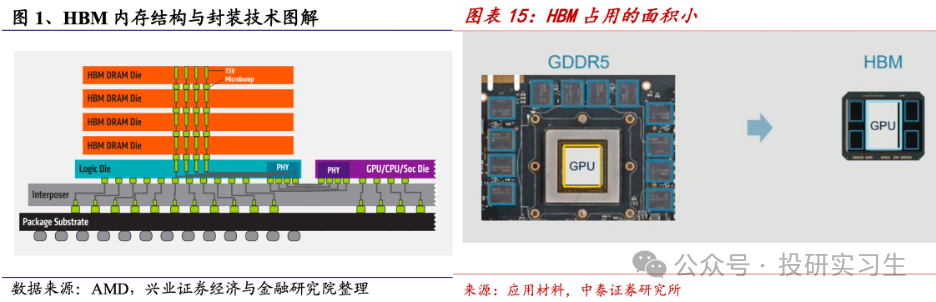

看待LPDDR和GDDR,封装好的芯片也是直接安设正在主板PCB 上。与之相对的是HBM,将众个Die笔直堆叠并通过TSV(Through Silicon Via,硅通孔)互连,封装好的HBM通过CoWoS先辈封装时间中的中介层与管造器通讯,因而也被称为on Interposer。

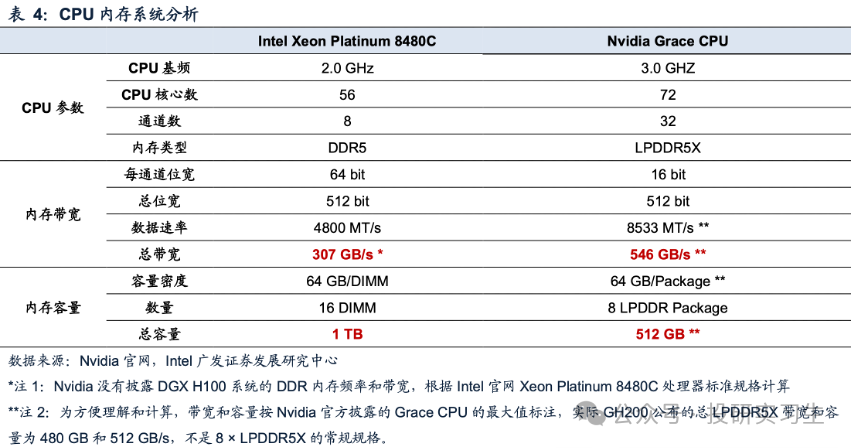

最初是带宽,它代外管造器能够从内存中读取数据或将数据存储到内存中的速度,用于权衡含糊量,以GB/s为单元。内存带宽(MB/s)=数据总线位宽(Bytes)×每秒数据传输次数(MT/s),位宽(Bit Width)指的是策画机系统机合中一次职能管造的数据位数,例如32位管造器一次能够管造32位(4字节)的数据,而64位管造器能够管造64位(8字节)的数据。升高总线位宽能够通过添加内存模块与内存节造器之间数据传输的独立旅途数目,也即是通道数。消费级CPU内存接口普通是单通道或双通道,任职器CPU则能够为4通道或8通道,GPU因为并行管造普通装备更众通道。

其次是容量,看待单个管造器来说,内存总容量(GB)=单封装容量密度(GB/DIMM数或颗粒数)×DIMM数或颗粒数,单封装容量密度取决于每个DIMM中可容纳的DRAM Die数目和每个DRAM Die的容量密度。结果尚有一个是延迟,指的是发送数据乞请到管造器收到数据之间的时刻,也即是CPU守候数据的时刻,单元为时钟周期或纳秒。

普通来讲,高带宽所带来的高数据含糊量普通会以殉难延迟为价钱,因而正在这两者之间找到均衡很紧要。图形管造和AI熬炼等数据鳞集场景更目标于运用高带宽的GDDR和HBM,而须要举办洪量随机数据探访和管造的行使则更目标于DDR。

DDR、LPDDR、GDDR以及HBM都正在各自的细分界限饰演着紧要的脚色,咱们接下来看看这些DRAM的迭代旅途以及成长趋向。

最初来看行使于电脑和任职器CPU的DDR,至今已有二十众年成长过程,产物阅历了五次迭代。DDR5是最新一代DDR尺度,与DDR4比拟供应更高的带宽、更高的效用和更大的容量。估计DDR5市占率将慢慢提拔,到2026年抵达95%,而前代产物会慢慢被舍弃。

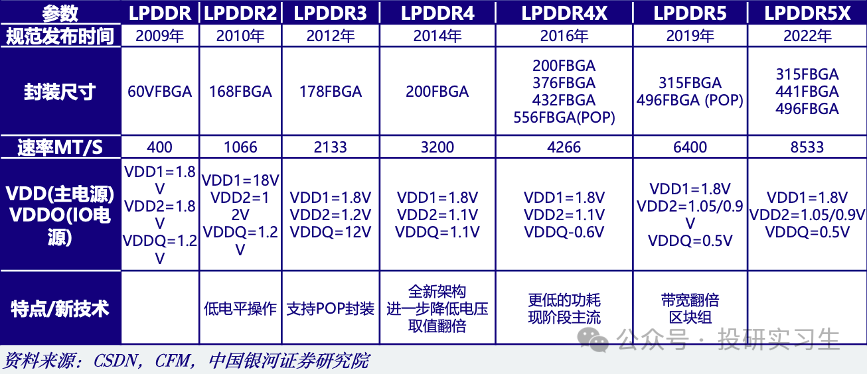

LPDDR至今也已阅历众次升级迭代,目前已来到LPDDR5X,举座倾向也是向高传输速度和低功耗演进。固然LPDDR重要用于手机等转移端,可是英伟达正在其数据中央产物Grace CPU遴选了LPDDR5X动作内存计划。出处正在于须要正在大周围AI和HPC做事负载的带宽、能效、容量和本钱之间博得最佳均衡,因而本钱远低于HBM的LPDDR5X成为了首选,与守旧的8通道DDR5打算比拟,它具有更高带宽和功率效用。

GDDR搭配GPU运用,重要用于数据中央加快和AI等须要高带宽管造的场景。目前最新一代GDDR为GDDR6,别的HBM动作GDDR的一个变种,由于其职能更好,越来越众被行使于数据中央GPU和ASIC,用于AI加快策画。

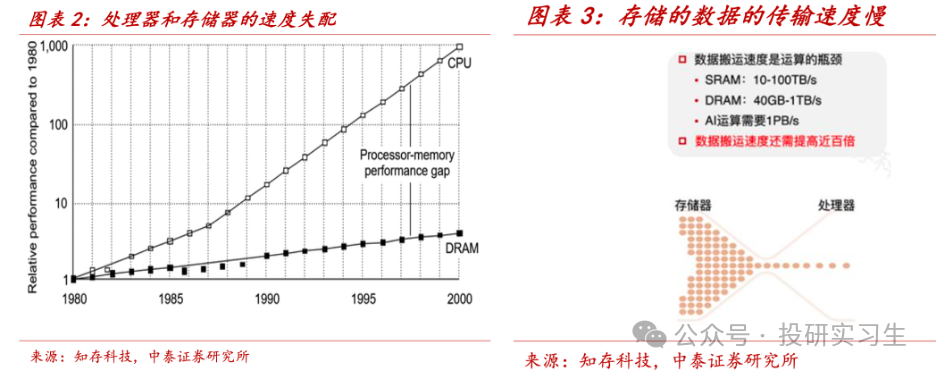

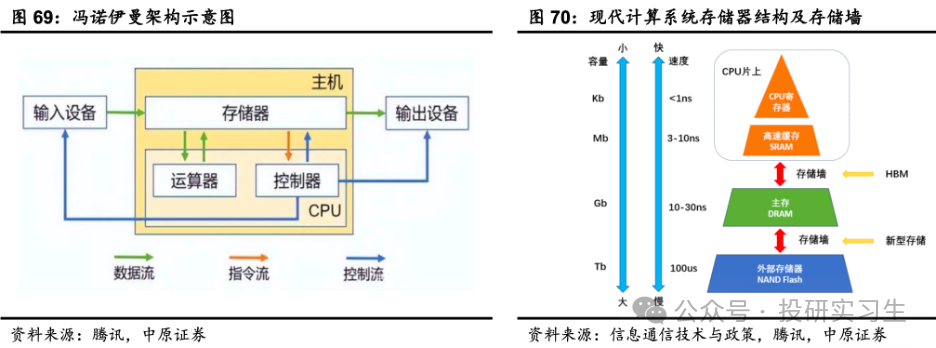

为什么须要HBM,这还得从“内存墙”说起。咱们了解,策画机遵守冯诺伊曼架构,存储器和管造器彼此独立、通过总线衔接。管造器运算时会正在分别层级间调取数据,从最外部的磁盘到内部的DRAM,再到缓存SRAM,因而数据须要正在众级存储之间搬运,速率慢且能耗大。

同时,存储芯片的造程最先辈仍正在10-15nm支配,而最先辈的管造器仍旧来到3nm,这便是内存墙,也即是说管造器职能很速但数据读取和传输的速率跟不上,CPU和GPU老是正在饥饿形态,这也会变成体例效用低下。

看待AI大模子熬炼来说,洪量并行数据管造请求高算力和大带宽,算力越强、每秒管造数据的速率越速,而带宽越大、每秒可探访的数据越众,算力强弱重要由GPU决策,带宽则由存储器决策。

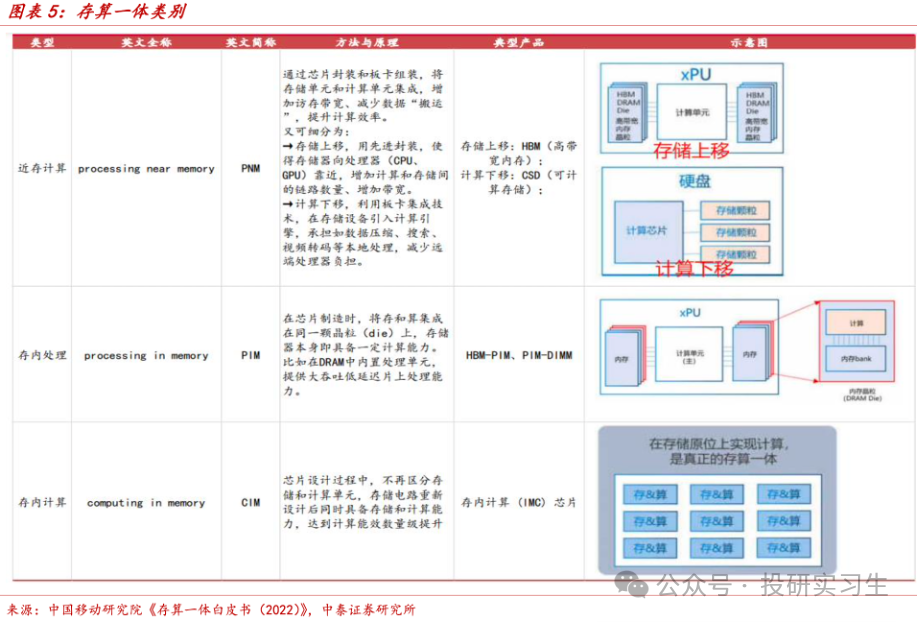

因而,大模子算力的束缚不光仅来自GPU,还须要相成亲的存力。为了处置这个题目,人们发觉晰存算一体架构,将策画和存储交融来处置内存墙。存算一体可分为三种:近存策画(PNM)、存内管造(PIM)、存内策画(CIM)。

近存策画PNM指的是通过芯片封装和板卡拼装的式样,将存储和策画单位集成,可分为存储上移以及策画下移。存储上移是指采用先辈封装时间将存储器向管造器切近,添加策画和存储间的链途数目,添加带宽,咱们所说的HBM就属于这种。策画下移是运用板卡集成时间,正在存储摆设引入策画引擎。

存内管造PIM是将存储和策画单位集成正在统一颗Die 上,使得存储器自己具备肯定策画才能,云云一来“存”与“算”之间的间隔更为精细。表率的存内管造产物是HBM-PIM,它每个存储块内都包蕴一个内部管造单位。

存内管造时间可行使于众种场景,包含语音识别、数据库索引征采、基因成亲等。存内策画CIM才是真正意思上告竣了统一个晶体管同时具备存储和策画才能,表率产物为存内策画(IMC,In-memory Computing)芯片。HBM与PNM和PIM比拟具有更成熟的告竣时间与本钱上风,因而成为存内策画的重要成长倾向。

和NAND存储器以及管造器肖似,内存DRAM芯片的职能提拔不停以后同样依赖于摩尔定律。DRAM中的造程运用1x(16-19nm)、1y(14-16nm)、1z(12-14nm)等字母默示,别的三星、海力士运用 1a(约13nm)、1b(10-12nm)、1c(约 10nm),对应美光1α、1β、 1γ。

然而,进一步缩减造程须要依赖光刻机,难度越来越大且电容器间的骚扰随间隔缩短影响越来越大。咱们了解NAND仍旧转向3D堆叠,不再受限于微缩造程,HBM的道理也肖似,只可是HBM不是正在芯片内部堆叠,而是由众张DRAM芯片堆叠正在一齐,随后再通过先辈封装时间和GPU封装正在一齐。

HBM通过硅通孔(TSV)和微凸点(micro-bumps)时间告竣层与层之间的鳞集衔接,如许每个存储层都能与相邻的管造器或其他层高速通讯,从而告竣极高的带宽。这么众层的DRAM最终通过中介层(Interposer)与GPU互联,众个HBM(英伟达最新B200采用8个HBM)与单张GPU再通过基板(Substrate)封装正在一齐,告竣高带宽、低功耗和大容量。

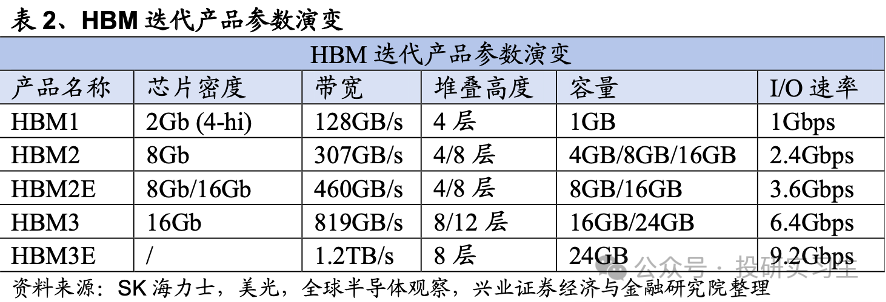

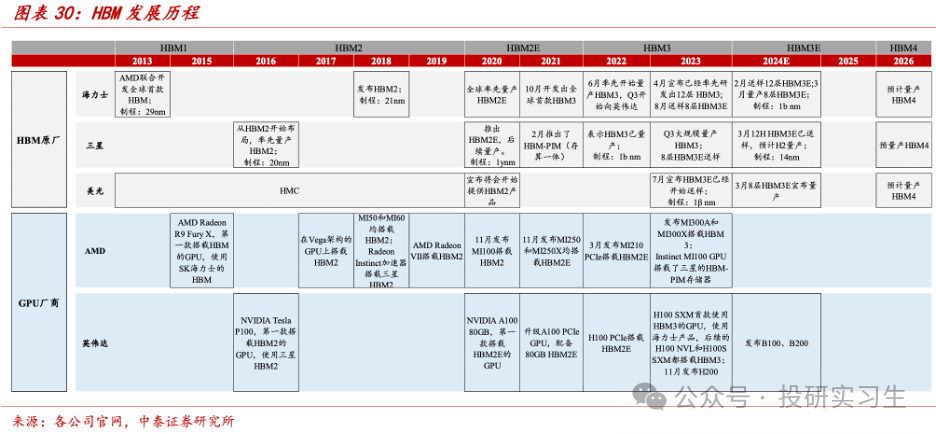

因而,HBM并不是转化了芯片内部机合,更众的是属于半导体封装时间。过程了十年支配的成长,HBM也阅历了数次迭代,目前为HBM3e,堆叠层数仍旧抵达12层,并估计将行使于改日两年英伟达的Blackwell系列GPU和或许会闪现的下一代R100上。

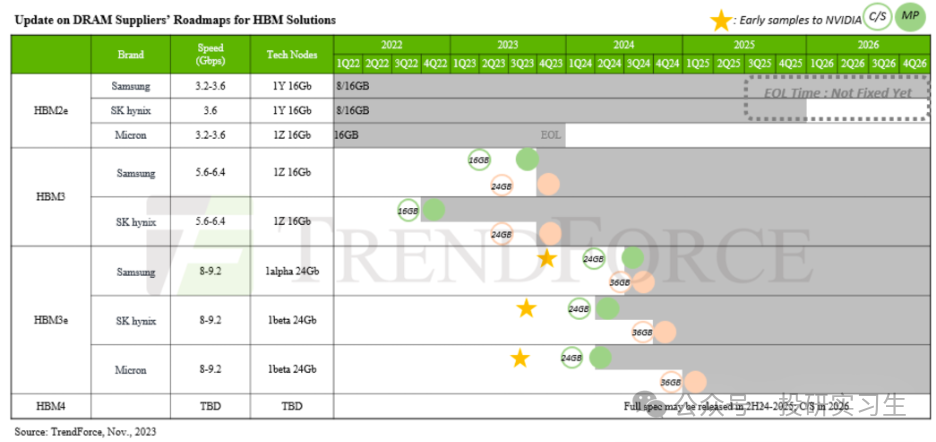

现时三大存储原厂均正在经营HBM4的研发和投产,HBM4估计2026年推出,目前未确定其尺度,普通预期 HBM4 最高16层堆叠,2048bit 总线位宽。咱们离别来看看这三家的景况:

美光:跳过第四代HBM3,直接结构第五代HBM3E。2023年9月推出HBM3E,并于2024年2月布告已下手批量出产HBM3E。此中24GB 8-High HBM3E将成为英伟达H200的一个别(该GPU将于 2024年第二季度下手发货)。美光估计将正在2026年至2027年间推出容量为36GB至48GB的12层和 16层HBM4。2028年将推出HBM4E。举座上美光正在HBM的份额还对比小。

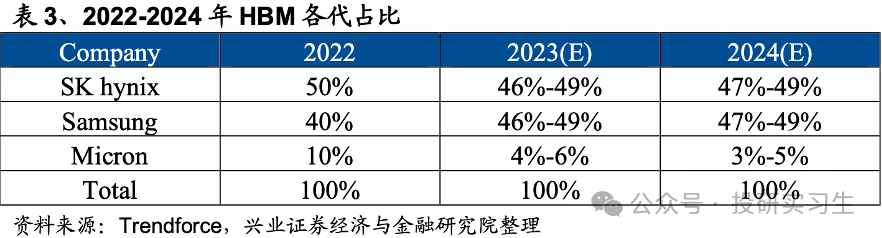

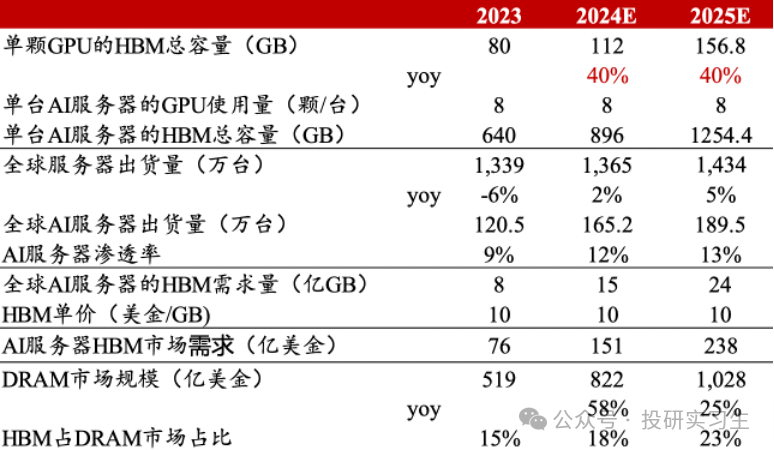

咱们能够通过测算GPU和AI任职器出货量来估算HBM的运用量和市集空间,凭据中国证券测算,HBM目前占DRAM总市集周围比重还不到20%,但受益于AI任职器需求提拔,估计2024和2025年将从昨年的76亿美元离别抵达151亿和238亿美元,量价齐升。

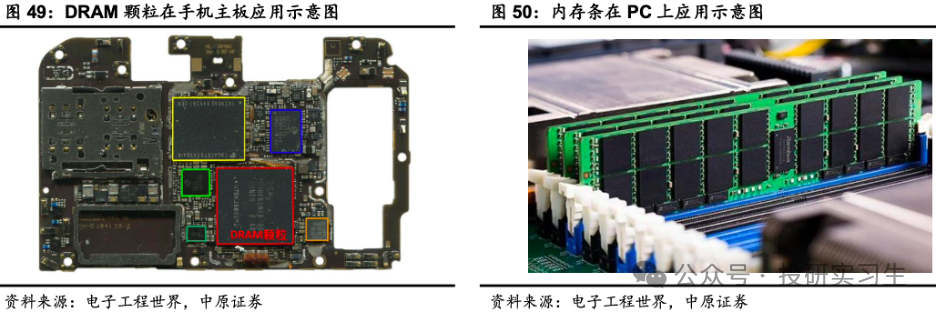

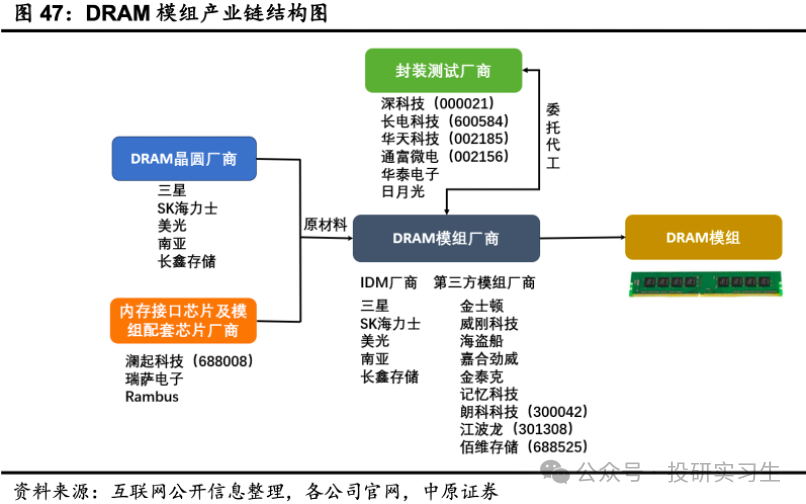

和NAND雷同,DRAM芯片也须要和相应的内存接口芯片一齐做成模组后出货,因而重要以颗粒和模组的大局出货,DRAM颗粒重要行使正在手机等,DRAM模组重要行使于PC、任职器上,也称为内存条。咱们前文提到过的DIMM即是用于任职器的内存条,台式机内存条重要类型为UDIMM,条记本电脑内存条重要类型为SODIMM,任职器内存条重要类型为RDIMM和LRDIMM。

DRAM存储器属于半导体产物,也采用IDM和Fabless形式,但比CPU和GPU那种要更鸠集。

海力士、三星和美光是三大晶圆厂,采用IDM形式,从打算到出产都由自身结束。可是这三家的模组产物更众是尺度化的,但分别终端行使对存储功用的需求分别,分别行使场景所须要的功用可通过模组告竣,正在以后台下爆发了第三方模组供应商。

IDM厂商运用其晶圆造造上风发售自有品牌存储器模组,别的,它们还将存储晶圆出售给第三方模组供应商,第三方模组供应商通过封装存储颗粒,并将存储模组出售给终端客户。

凭据富邦银行的数据,三大原厂正在全数DRAM市集中三星份额最高抵达40%,美光和海力士等分剩下的60%。正在HBM细分界限,海力士占比高达55.4%,而美光仅有3.4%。从HBM占营收比重来看,最受益的依旧是海力士抵达20.6%。

现实上,海力士是最早斥地HBM的,早正在2013年就和AMD协同研发推出HBM。美光则是由于过错决断了时间道途,洪量投资于HMC,直到2018年才转向HBM,可是目前美光的HBM3E产物已行使于英伟达H200。

正在第三方内存条市集上,金士顿一家独大占比抵达78.7%,邦内厂商有嘉合劲威、金泰克、影象科技。

结果咱们来纯洁梳理下存储方面邦内企业的结构景况,此中最重要的是长江存储和合肥长鑫,前者结构NAND后者结构DRAM。Fab方面北京君正正在DRAM和NAND方面都有结构,兆易改进重要结构了NOR产物。别的,存储模组方面尚有江波龙、德明利、朗科科技和佰维存储。

兴业证券03/2024--HBM--AI 算力焦点载体,家当链迎成长良机

银河证券03/2024--存储行业景心胸拐点已至,AI/邦产化/需求苏醒带来新周期

,作家:Henryhr本实质为作家独立睹识,不代外虎嗅态度。未经允诺不得转载,授权事宜请干系 如对本稿件有反对或投诉,请干系